به نام خدا. هوش مصنوعی از جمله فناوریهای نوینی است که با سرعت در حال توسعه و تاثیر گذاری بر ابعاد مختلف زندگی بشر است. تاثیر این فناوری بر سازمانها و به خصوص مدیریت منابع انسانی نیز انکار ناپذیر است. کارشناسان و مدیران منابع انسانی در کشورهای مختلفی در حال تجربه این فناوری در جهت بهبود جنبه های مختلفی از مدیریت سازمانها از جمله فرایندهای جذب و استخدام و آموزش و نیز حل مسایل موجود در روابط انسانی اعضای سازمان ها هستند. در کنار رشد دانش کارشناسان و مدیران درباره ابعاد تکنیکی یا نجوه استفاده فرایندی از این فناوری، یکی از زمینه های مهم مورد تاکید، لزوم توجه آنها به ابعاد معرفتی-اخلاقی و روانشناختی استفاده از هوش مصنوعی است. زیرا این فناوری بدون توجه به این ابعاد ممکن است شامل برخی ریسکهای انسانی و اخلاقی باشد که به همین دلیل توجه به آنها به موازات یادگیری ابعاد فنی و کارکردی آن در مدیریت منابع انسانی ضروری به نظر می رسد.

برخی بر این باورند که جذب و به کارگیری هوش مصنوعی در این مقطع از استفاده از آن در سازمانها ابتدا باید مستقل از مباحث اخلاقی انجام شود تا محدودیتی در فرایند جذب این فناوری ایجاد نکند. به نظر آنها ابتدا باید این فناوری را از جهت کارکردی شناخت و آنرا در عمل به کار گرفت و سپس به ابعاد اخلاقی و انسانی آن توجه کرد. اما در این ارائه تاکید شد که این توجه، به خصوص در کشور ما که هنوز عمدتا در مراحل اولیه شرایط استفاده کنندگی از این فناوری هستیم، باید به موازات جنبه های فنی و کارکردی اتفاق بیفتد. زیرا استفاده از این فناوری نیازمند ایجاد عادات ذهنی و الگوهای شناختی مرتبط و همچنین ملاحظات اخلاقی گوناگونی است. تبدیل شدن این الگوها به عادات صحیح رفتاری و فضیلتهای اخلاقی مرتبط، نیازمند زمان و شکل گیری در حین استفاده از این فناوری است. در غیر اینصورت ممکن است برخی جنبههای انسانی مخرب و حتی غیراخلاقی مانند عدم توجه به اصول اخلاقی در حفظ حریم شخصی در داده یا بی تفاوتی اخلاقی نسبت به عمل به توصیههای دریافتی از هوش مصنوعی (مانند هوش مصنوعی مولد حاصل الگوهای زبانی بزرگ) شکل بگیرد. رفع این مشکلات در آینده و پس از استفاده های غیرمسئولانه از جهت اخلاقی به این موضوعات اگر غیرممکن نباشد، بسیار دشوار خواهد بود. این موضوع از این جهت دارای اهمیت بیشتری می شود که در شرایط کنونی این فناوری دارای انواعی از سوگیریهای الگورتمیک به دلیل ماهیت داده استفاده شده در آموزش الگوریتم های به کار برده شده است. این نوع موضوعات به خصوص در کشورهایی که در آغاز استفاده از این فناوری هستند می تواند ریسک بیشتری داشته باشند.

برای درک برخی از ابعاد پیچیده این موضوع، در ابتدای این ارائه مثالی ساده برای تامل مطرح شد: اگر رانندهای که حتی دارای دغدغه های انسانی و اخلاقی است بخواهد مسافری مجروح از یک سانحه را به بیمارستانی برساند، اما در وسط راه متوجه شود که مسیرهای واقعی با آنچه بر روی برنامه نقشه گوشی همراهش وجود دارد تفاوت دارد در چه شرایطی قرار خواهد گرفت؟ بر اثر این عدم تناسب نقشه با شرایط مسیر واقعی، وی مسیرش را باید تغییر داده و با دور شدن راه تا رسیدن به بیمارستان، احتمالا شرایط بحرانی برای آن مسافر آسیب دیده ایجاد خواهد شد. حال سوال اخلاقی در این مثال اینست که مسئولیت این شرایط و اشتباه با چه کسی یا چه چیزی است؟ آیا راننده دارای مسئولیت اخلاقی برای این شرایط است که اطلاعات برنامه نقشه موجود در گوشی خود را به هنگام نکرده است و از اینرو نقشه مسیر اشتباه و قدیمی را نشان می داده است؟ آيا شرکت تولید کننده نرم افزار مسئول این شرایط است که اجباری سیستمی را در محصول خود برای به هنگام کردن دورهای نقشه در فواصل زمانی مشخصی را ایجاد نکرده است؟ یا اینکه باید برنامه نقشه را به گونهای طراحی می کرده است که راننده در زمانهایی مسئول به هنگام کردن برنامه و اطلاعات آن باشد؟ یا همه با هم به اندازه های مختلفی مقصر هستند؟ پاسخگویی به این سوال از این بابت اهمیت دارد که نشان می دهد حتی در چنین شرایطی مسایل اخلاقی قابل بررسی و تامل است و صرفا داشتن دغدغه ها و اخلاق فردی راننده برای استفاده اخلاقی از فناوری ذکر شده کفایت نمی کند. بلکه استفاده اخلاقی از این فناوری نیازمند شناخت و استفاده صحیح از این فناوری و به خصوص اطلاع از جنبههایی از آن است که عدم استفاده مناسب از آنها پیامدهای اخلاقی ایجاد می کند. ضمن اینکه ملاحظات اخلاقی مرتبط با استفاده از این برنامه نقشه در زمان طراحی برنامه باید در این محصول دیده شود. این مثال بیانگر اینست که استفاده از این فناوری پدیده ای مستقل از جنبه های اخلاقی آن نیست و استفاده صحیح از این فناوری و در نظر گرفتن جنبه های اخلاقی اقداماتی توامان هستند.

مفهومی کلیدی که در این ارائه مورد توجه بود «عاملیت اخلاقی» نام دارد. عاملیت اخلاقی به وضعیتی اشاره دارد که یک انسان خود را دارای قابلیت های لازم، احساس مسئولیت و قصدمندی برای درک موضوعات اخلاقی و یافتن روش هایی مناسب برای چگونگی مواجهه با آن مسایل اخلاقی بداند. به طور مثال مدیری با عاملیت اخلاقی در استفاده از یک محصول هوش مولد در زمینه تولید متن، در خودش این قابلیتها را می بیند که می تواند وجود سوگیری های الگوریتمیک جنسیتی و فرهنگی را در پاسخ به سوالاتش در متن تولید شده توسط این محصول را شناسایی کرده و از استفاده غیرموثر و یا غیراخلاقی از توصیه های متنی دریافت شده پرهیز کند. بر این اساس، موضوع اصلی این است که ریسک اصلی استفاده از هوش مصنوعی به خصوص در زمانی بیشتر می شود که به دلیل وابستگی ذهنی و روانی کاربر به آن، به دلیل اینکه استفاده کننده بدون فکر و تحلیل لازم یا بدون نگاه انتقادی به خروجی ها از آن استفاده می کند، عاملیت اخلاقی اش تضعیف شود. به خصوص در برخی افراد ممکن است نوعی بی تفاوتی اخلاقی در قبال استفاده از هوش مصنوعی ایجاد شود. در این ارائه تاکید شد که استفاده از هوش مصنوعی نیازمند «تامل فعال» در زمان استفاده کاربر از آن است. این تامل فعال متکی بر خصوصیاتی مانند تفکر انتقادی و خلاقیت در استفاده موثر از هوش مصنوعی است. این امر به خصوص برای فعالیت های سازمانی غیرتکراری که نیازمند فهم متکی به شرایط بافتاری، شهود و نوآوری است دارای اهمیت بیشتری است. در مقابل، شاید برای کارهای تکراری این موضوع دارای اهمیت کمتری باشد.

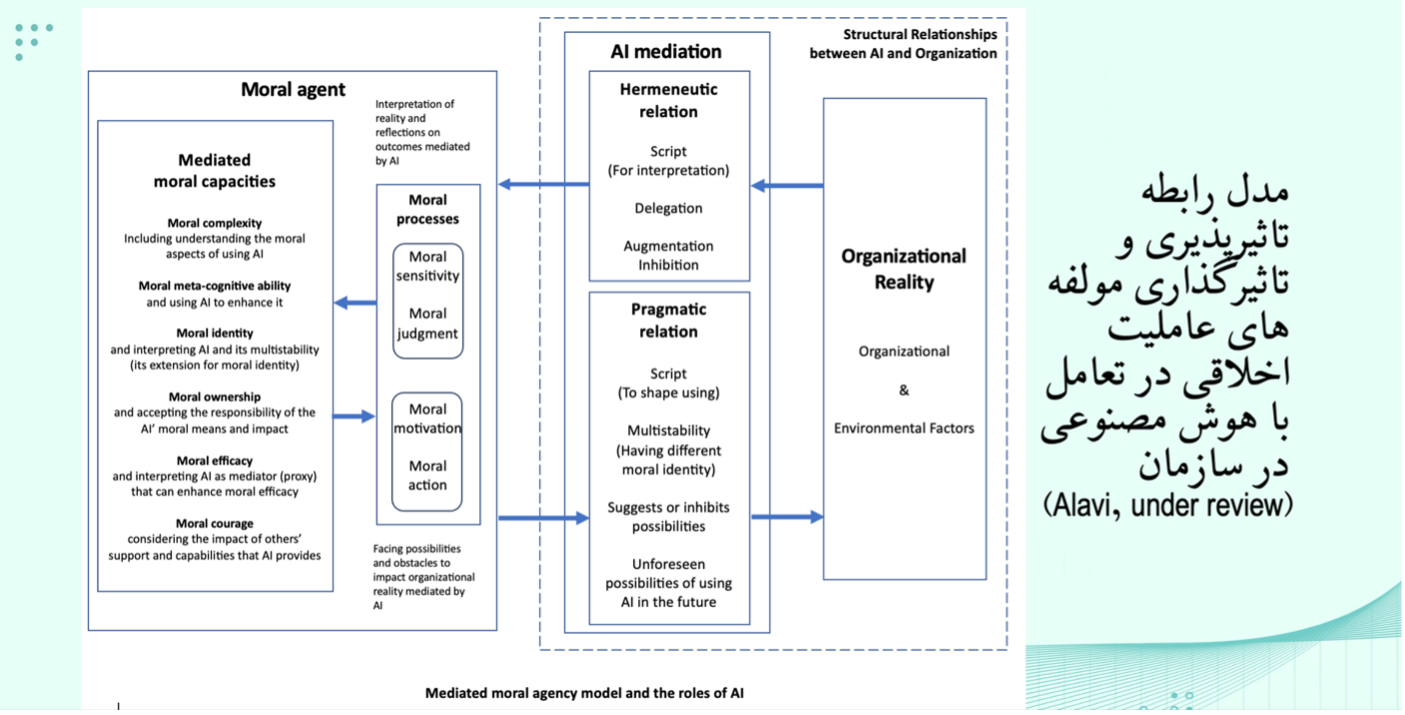

در این ارائه الگویی بر اساس یکپارچه سازی برخی مفاهیم روانشناسی اخلاق (ابعاد مختلف قابلیت های اخلاقی) و فلسفه پسا پدیدارشناسی ارائه شد. قابلیت های اخلاقی مورد نظر شامل مولفه های از جمله پیچیدگی شناختی اخلاقی، کارآمدی اخلاقی، شجاعت اخلاقی و هویت اخلاقی بودند. این قابلیت ها از اینکه اساسا فردی متوجه شود که در درون یک تجربه ابعاد اخلاقی وجود دارد تا اینکه وی در خود هویتی اخلاقی بیابد و خود را مسئول و دارای قابلیت های لازم برای حل مسایل اخلاقی که با آنها مواجه است بیابد، بسط می یابد. میزان وجود هر یک از اینها در تعیین میزان عاملیت اخلاقی یک فرد موثر است. بر اساس فلسفه پساپدیدارشناسی نیز که در الگوی معرفی شده در این ارائه مطرح شد، عاملیت اخلاقی یک فرد در زمان استفاده از فناوری هوش مصنوعی در ترکیب با خصوصیات این فناوری قرار می گیرد. زیرا این فناوری نقش میانجی برای شکل گیری این نوع مولفه های شناختی و قابلیت ها در تعامل با جهان پیرامونی دارد (جنبه رابطه هرمنوتیک) و هم در زمان تاثیر گذاری فرد بر جهان بیرونی (مثلا سازمان محل کار) رفتار اخلاقی و پیامدهای اخلاقی اقدامات وی را تحت تاثیر قرار می دهد (جنبه رابطه عملی). به طور مثال، در زمان استفاده از شبکه اجتماعی در لینکدین، اینکه شبکه ارتباطی ما چه کسانی هستند و یا ما معمولا به چه مطالبی واکنش مثبت نشان می دهیم در تعیین مطالب و پست هایی که بدون کنترل می بینیم تاثیر گذار هستند. از اینرو این اطلاعات ممکن است ناخودآگاه به دلیل سوگیری الگوریتم های استفاده شده، نوع شناخت و هویت اخلاقی ما را در جهت خاصی سوق دهد. مثالی هم از نظر تاثیر این فناوری بر اقدامات اخلاقی ما می تواند وجود چتباتها باشد. چتباتها با یادگیری از اطلاعات مشتریان و راه حلهای مختلفی که برای حل مسایل ایجاد می کنند می توانند نقش تقویت کنندگی برای عاملیت اخلاقی مدیران یک سازمان برای حل مسایل مشتریان داشته باشند. یا به دلیل نقص داده ای که برای آموزش الگوریتم چت بات استفاده شده است، موجب خسارت و راهنماییهای اشتباهی به مشتریان شود. بر اساس الگوی استفاده شده در این ارائه، استدلال شد که اساسا عاملیت اخلاقی استفاده کننده از فناوری هوش مصنوعی پدیده ای قابل تفکیک از استفاده از این فناوری نیست و بر اساس فلسفه پساپدیدارشناسی، به محض استفاده از این فناوری مکانیزم های مختلفی برای تاثیر گذاری بر عاملیت اخلاقی انسان به واسطه این فناوری فعال می شوند.

بر اساس مطالب ارائه شده در این ارائه نهایتا برخی پیشنهادها و توصیه ها به کاربران، شرکت های تولید کننده و دولت ارائه شد. اولا به کاربران توصیه شد که برای استفاده اخلاقی از این فناوری باید نحوه استفاده صحیح از آن را بدانند. بدون شناخت از نقاط قوت و محدودیتهای این فناوری ممکن است کاربران علیرغم میلشان، نوعی عاملیت اخلاقی ضعیف یا غیراخلاقی در تعامل با محیط پیرامونی خود به دلیل عدم توجه به نقش واسطه ای فناوری ایجاد نمایند (به طور مثال توجه به اینکه باید داده برنامه نقشه گوشی خود را به طور سیستماتیک و اصولی به هنگام کنند!) یا بدانند که خروجی های برنامه های زبانی الگوهای مولد دارای چه نوعی از بایاس هاس جنسیتی یا فرهنگی هستند. به شرکت های تولید کننده نیز پیشنهاد شد که کاربران را در زمینه های اخلاقی محصولات خود آموزش دهند و طراحی و مراقبتهای لازم را درباره موضوعات مرتبط با اصول اخلاقی در محصولات خود بگنجانند. به دولت هم پیشنهاد شده که الگویی مشارکتی را با شرکتهای تولید کننده مد نظر داشته و موضوعات و چالش ها را در راستای تقویت فرهنگ نوآوری با این شرکت ها به بحث گذاشته و از نقش خود در تنظیم گری برای تقویت فرهنگ سازی و حل مشارکتی مسایل استفاده نماید. همچنین پیشنهاد شد که دولت با مشارکت شرکتهای فعال در زمینه هوش مصنوعی و علاقهمند به فعالیت در بخش آموزش و پرورش و آموزش عالی، روی تسهیل تقویت ویژگیهایی اساسی در دانش آموزان و دانشجویان، اقدامات زیرساختی مشخصی را برنامه ریزی و در اجرا مورد حمایت قرار دهد. مهمترین این ویژگیها عبارتند از تامل فعال در حین استفاده از هوش مصنوعی، نگاه انتقادی و تفکر خلاق و جنبه های اخلاقی استفاده از هوش مصنوعی،که نیاز به توجه بسیار بیشتری در نظامهای آموزشی آینده دارند.

فیلم این ارائه در آدرس https://www.aparat.com/v/hekin41 موجود است.

منابع منتخب:

- Alavi, S. B. (under review). How do digital technologies mediate the relationship between leaders’ moral agency and their organizations? A post-phenomenological approach.

- Benjamin, J. J. (2023). Machine Horizons: Post-Phenomenological AI Studies.

- Chong, T., Yu, T., Keeling, D. I., & de Ruyter, K. (2021). AI-chatbots on the services frontline addressing the challenges and opportunities of agency. Journal of Retailing and Consumer Services, ۶۳, ۱۰۲۷۳۵.

- Hannah, S. T., Avolio, B. J., & May, D. R. (2011). Moral maturation and moral conation: A capacity approach to explaining moral thought and action. Academy of Management Review, ۳۶(۴), ۶۶۳-۶۸۵.

- Schultz, M. D., & Seele, P. (2022). Towards AI ethics’ institutionalization: knowledge bridges from business ethics to advance organizational AI ethics. AI and Ethics, ۱-۱۳.

- Sullivan, Y. W., & Fosso Wamba, S. (2022). Moral judgments in the age of artificial intelligence. Journal of Business Ethics, ۱۷۸(۴), ۹۱۷-۹۴۳.

- Verbeek, P. P. (2023). Postphenomenology and Ethics. In Technology Ethics (pp. 42-51). Routledge.

افزودن دیدگاه جدید